Faktenchecks Pinocchio for President

Was ist wahr, was ist Lüge? So manche Empörungsmeldung im Internet entpuppt sich später als schlicht erfunden. Faktenchecker*innen, die Informationen verifizieren, kommt daher im Social-Media-Zeitalter eine besondere Rolle zu. Ein Blick auf die Möglichkeiten und Grenzen des Enttarnens von Fake-News.

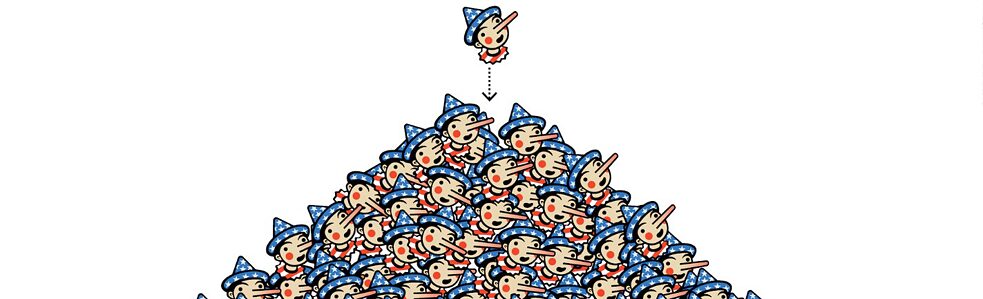

Es waren kleine Pinocchios, die viele Menschen das erste Mal mit Faktenchecks in Berührung brachten: 2011 begann der US-amerikanische Journalist Glenn Kessler bei der Washington Post damit, Fakten in Reden von Politiker*innen zu überprüfen. Um Bewertungen wie „teilweise richtig“ oder „größtenteils falsch“ den Leser*innen besser verständlich zu machen, begann die Redaktion, den Faktencheck-Artikeln Bilder kleiner Pinocchios hinzuzufügen. Je mehr Pinocchios mit langer Lügennase, desto mehr Fehler und falsche Behauptungen hatten sie gefunden.

Insbesondere während des US-Wahlkampfes von Donald Trump 2016 wurde das Konzept immer bekannter. Trump selbst machte öffentlich Witze, er müsse aufpassen, was er sage, um nicht noch mehr Pinocchios von der Washington Post zu bekommen. Seine Aussagen fielen bei der Washington-Post-Redaktion immer wieder in die Kategorie „Bottomless Pinocchio“. Diese kennzeichnet Falschaussagen, die über 20 Mal wiederholt wurden, so dass man von bewusster Desinformation ausgehen kann.

Die 2018 von der Washington Post eingeführte Bewertungskategorie „Bottomless Pinocchio“ vergibt die Redaktion, wenn Politiker*innen eine falsche Behauptung mehr als 20 Mal wiederholen. Donald Trump wurde diese Auszeichnung viele Male zuteil.

| Foto (Detail): © Screenshot Washington Post/Steve McCracken

Weltweit gründeten in der Zeit des US-Wahlkampfs immer mehr Medienhäuser eigene Teams, die gezielt nach falschen Informationen – sogenannten Desinformationen – im Netz suchen und diese in Faktenchecks erläutern und richtigstellen. Schnell nutzten auch jene, die selbst Fakenews verbreiteten, die Gunst der Stunde und schmückten sich mit dem nicht geschützten Begriff der „Faktenchecker“. Das sorgte für Verwirrung und stellte die Glaubwürdigkeit von Fact-Checking generell in Frage.

Die 2018 von der Washington Post eingeführte Bewertungskategorie „Bottomless Pinocchio“ vergibt die Redaktion, wenn Politiker*innen eine falsche Behauptung mehr als 20 Mal wiederholen. Donald Trump wurde diese Auszeichnung viele Male zuteil.

| Foto (Detail): © Screenshot Washington Post/Steve McCracken

Weltweit gründeten in der Zeit des US-Wahlkampfs immer mehr Medienhäuser eigene Teams, die gezielt nach falschen Informationen – sogenannten Desinformationen – im Netz suchen und diese in Faktenchecks erläutern und richtigstellen. Schnell nutzten auch jene, die selbst Fakenews verbreiteten, die Gunst der Stunde und schmückten sich mit dem nicht geschützten Begriff der „Faktenchecker“. Das sorgte für Verwirrung und stellte die Glaubwürdigkeit von Fact-Checking generell in Frage.

Das US-amerikanische Journalismus-Institut Poynter erkannte das Problem und gründete 2015 das Internationale Faktencheck Netzwerk (IFCN), in dem sich aktuell 121 Faktencheck-Organisationen zu einem gemeinsamen Grundsatzkodex bekennen. Sie werden jährlich auf die Einhaltung der Kriterien wie parteipolitische Unabhängigkeit, transparente Recherche und Offenlegung der Finanzierung kontrolliert. Trägt eine Faktencheck-Redaktion das Siegel des IFCN, ist sie deshalb mit hoher Wahrscheinlichkeit seriös. Für Leser*innen ist das Siegel besonders dann hilfreich, wenn sie nach vertrauenswürdigen Quellen in Ländern suchen, in denen sie die Presselandschaft nicht gut kennen oder die Landesprache nicht sprechen. Eine aktuelle Liste der Unterzeichner gibt es hier im Netz.

Zu wenig Faktenchecker*innen für alle Fakes

Wen aber erreichen die Faktencheck-Teams mit ihren Recherchen? Medienorganisationen veröffentlichen ihre Faktencheck-Artikel in der Regel auf ihren eigenen Webseiten und erreichen damit die bestehende Leserschaft. Das sind aber nicht unbedingt die Personen, die auf die Fakes reingefallen sind. Denn Desinformationen werden insbesondere über Plattformen wie Instagram, Facebook, TikTok, YouTube und Co verbreitet. Daher liegt es nahe, auch dort Fakten zu verifizieren.

Nach großem politischem Druck haben mittlerweile fast alle großen Plattformen entsprechende Programme gestartet und arbeiten mit Faktenchecker*innen zusammen. Voraussetzung ist in der Regel, dass die jeweilige Faktencheck-Organisation IFCN-Mitglied ist. Wie viele Menschen mit den Faktenchecks auf den Plattformen erreicht werden, wissen aber letztlich nur die Firmen selbst. Die Datenzugänge für unabhängige Forschung wurden von den Plattformen in den vergangenen Jahren systematisch beschränkt. Diese fehlende Transparenz ist ein grundlegendes Problem.

Die Plattformen geben jedoch selbst zu, dass die Faktenchecker*innen bei weitem nicht ausreichen, um alle Fakes zu prüfen. Schon 2018 formulierte Facebook deshalb als Ziel, diese Lücke durch künstliche Intelligenz weiter schließen zu wollen. Zahlreiche Faktencheck-Organisationen arbeiten bereits selbst an automatisierten Ansätzen, um mehr Inhalte in kürzerer Zeit prüfen zu können oder mehr Menschen mit Faktenchecks zu erreichen. Manche Tools werden schon in der Praxis angewandt. So bietet zum Beispiel das deutsche Faktencheck-Team des Recherchezentrums Correctiv seit 2020 einen WhatsApp-Chatbot an. Leser*innen können dort Bilder, Videos oder Sprachnachrichten einreichen, hinter denen sie Falschinformationen vermuten. Falls der Bot einen Faktencheck dazu im Archiv findet, wird die Information automatisch als Antwort zurückgesendet.

Kann künstliche Intelligenz Desinformation enttarnen?

Bei einer Internationalen Faktencheck-Konferenz im Juni 2022 in Oslo tauschten sich zahlreiche Organisationen zum aktuellen Stand der Unterstützung durch künstliche Intelligenz aus. Für fast alle Teile des Faktencheck-Prozesses gibt es mittlerweile Möglichkeiten diese zu automatisieren. Bisher sind die meisten dieser Tools jedoch nicht für die Öffentlichkeit verfügbar. So berichteten Kate Wilkinson von der britischen Faktencheck-Redaktion FullFact und Pablo Fernández von der argentinischen Organisation Chequeado von einem von ihnen entwickelten Tool, das Webseiten nach Tatsachenbehauptungen durchsucht (denn nur die sind faktencheckbar) und mithilfe künstlicher Intelligenz auch gezielt relevante Statistiken zur Überprüfung dieser Behauptungen findet. Bill Adair vom US-amerikanischen Faktencheck-Projekt Politifact erzählte von einem neu entwickelten Tool, das automatisiertes Live-Fact-Checking von Videos ermöglichen soll. So erkenne das Tool in Echtzeit Behauptungen in Videos und zeige passgenau Faktenchecks aus einem Datensatz an.

Ist es also nur eine Frage der Zeit, bis Faktenchecker*innen überflüssig sind? Noch sieht es nicht so aus. Einerseits sind die Tools nicht fehlerfrei, es kommt zum Beispiel zu falschen Sprach-Text-Übersetzungen. Andererseits sind fundierte Auswertungen oft kompliziert und passen nicht in eine simple Einordnung als entweder „Fake“ oder „kein Fake“.

Die Tools können zwar zum Beispiel erkennen, dass ein Foto in der Vergangenheit für falsche Behauptungen genutzt wurde, und es als Desinformation markieren. Diese Vorgehensweise führt jedoch auch zu falschen Treffern. Denn manche Menschen teilen das Bild auch, um auf den Fake aufmerksam zu machen. In anderen Fällen wird durch hinzugefügten Text deutlich, dass es sich um Satire oder Ironie handelt. Solche Feinheiten stellen für automatisiertes Fact-Checking ein Problem dar.

Hinzu kommt: Von Beginn an haben sich die großen Plattformen bei der Einführung von Fact-Checking auf Märkte im Globalen Norden fokussiert – wohl auch, weil primär dort Regulierungen drohten. Für zahlreiche Sprachen in Ländern des Globalen Südens gab es lange keinerlei Faktenchecking-Bemühungen. Auch die Entwicklung automatisierter Tools findet im Moment vornehmlich auf europäischen Sprachen wie Englisch statt.

Faktenchecker*innen werden für den Kampf gegen Desinformation also weiterhin zentral sein. Automatisierte Tools können zwar den Faktencheck-Prozess enorm beschleunigen, aber die Pinocchios vergeben noch immer Menschen.

Hinzu kommt, dass fast alle großen Faktencheck-Organisationen neben dem Überprüfen von Fakes auch auf Medienbildung setzen. Denn Desinformationen können sich nur im großen Stil effektiv verbreiten, wenn viele Menschen darauf reinfallen. Langfristig werden auch die besten Tools dieses Problem nicht lösen können. Es gibt nur einen Weg: Jede*r sollte in der Lage sein, selbst grundlegende journalistische Verifikationstechniken anzuwenden. Zum Beispiel Kriterien für seriöse Quellen kennen, Bilder und Videos verifizieren und Behauptungen im Netz überprüfen können. Dafür braucht es umfassende Medienbildung, die alle in der Gesellschaft erreicht.

0 Kommentare