KI in der Gesellschaft

Wissenschaftler*innen sehen künstliche Intelligenz (KI) als Schlüsseltechnologie, deren Anwendung in allen Gesellschaftsbereichen zu erwarten ist. KI kann die Lebensqualität vieler Menschen erhöhen und bei der Bewältigung weltweiter Herausforderungen wie Klimawandel oder Gesundheitskrisen helfen.

Auf der ganzen Welt wird schon heute sehr viel Geld für die Entwicklung von KI-Systemen bereitgestellt. Das zeigt, wie hoch das wirtschaftliche Potenzial der KI ist. Mit der zunehmenden Nutzung von KI-Anwendungen wachsen aber auch die Bedenken, zum Beispiel in Bezug auf die Bedeutung menschlicher Werte wie Fairness, Freiheit, Datenschutz, Sicherheit und Haftung. Wohl kaum eine andere Entwicklung stellt uns derzeit so deutlich und umfassend die Frage, wie wir unsere technischen Fähigkeiten im gesellschaftlichen Zusammenhang sehen wollen. Sicher ist, dass diese Technologie unseren Alltag schon jetzt tiefgreifend verändert hat und weiter verändern wird.

Moral für Maschinen

Algorithmen verändern durch Dating-Apps das Liebesleben vieler Menschen, verwalten das Smart Home, treffen Kaufentscheidungen und beeinflussen die öffentliche Debatte. KI wird Kinder betreuen, Kranke pflegen, Jobs und Kredite vergeben und in autonomen Waffen über Leben oder Tod entscheiden. Intelligente Maschinen werden eigene Verhaltensmuster entwickeln, die sich weder eindeutig programmieren noch mit der traditionellen Verhaltensforschung erklären lassen. Aber ist ethisches Handeln ohne Bewusstsein und Gewissen überhaupt denkbar? Wie also können wir KIs entwickeln, die den Menschen dienen und nicht schaden? Viele KI-Expert*innen sind überzeugt, dass nur ein neues Forschungsgebiet diese Fragen beantworten kann: „Machine Behaviour“, Verhaltensforschung für Maschinen. Eines jedenfalls ist klar: Wir müssen heute grundlegende Fragen der Ethik und Moral klären, wenn sich Maschinen in Zukunft danach verhalten sollen.

The Moral Machine

Iyad Rahwan forscht am Max-Planck-Institut für Bildungsforschung in Berlin und am MIT Media Lab in Boston. Sein Projekt „The Moral Machine“ ist die bisher größte Studie auf dem Gebiet der Maschinenethik. Die interaktive Umfrage untersucht, aus welchen ethischen Gründen Menschen in verschiedenen Weltregionen Entscheidungen treffen und ob daraus Verhaltensregeln für KI entwickelt werden können. Wie soll sich ein autonom fahrendes Auto verhalten, wenn ein schwerer Unfall nicht zu verhindern ist? Die KI muss entscheiden, wohin sie das Auto steuert – und damit auch, wer überlebt. Es zeigt sich: Alle Befragten wollen möglichst viele Menschenleben retten, Kinder zuerst und diejenigen, die sich an die Verkehrsregeln halten. Doch bei genauerem Hinsehen wird klar, dass es keine weltweit gültigen Werte gibt. So möchten Teilnehmer*innen aus Frankreich und Südamerika überwiegend eher Frauen und Kinder retten als Männer, Japaner*innen auch ältere Menschen und die meisten Deutschen möchten nicht eingreifen und das „Schicksal“ entscheiden lassen, wer sterben muss.

Auf Fairness programmiert

Wer bekommt einen Kredit? Wer wird zum Jobinterview eingeladen? Wer kommt früher aus dem Gefängnis? In Zukunft werden Computer immer häufiger über Menschen (mit-)entscheiden. Dabei dürfen einzelne Personengruppen nicht besser oder schlechter behandelt werden als andere – auch nicht unbeabsichtigt. Bei automatischen Systemen, die bereits eingesetzt werden, passiert das immer wieder. Warum? Und wie kann eine KI lernen, sich fair zu verhalten? Zunächst muss sicher sein, dass die KI nicht aufgrund der Daten diskriminiert, mit denen sie „gefüttert“ wird. Darüber hinaus spielt es eine große Rolle, inwieweit Computer eine sinnvolle Beziehung zwischen Ursache und Wirkung herstellen können. Einfache „wenn-dann-Beziehungen“ führen hier oft in die Irre. Diese sogenannte Kausalität maschinellen Lernens ist ein sehr aktuelles Forschungsgebiet: Zusammenhänge müssen aufwendig analysiert und in Algorithmen programmiert werden. Aber zu guter Letzt bleibt die Frage „Was ist eine faire Entscheidung?“ Denn es gibt keine Definition von Fairness, die für alle Kulturkreise gleichermaßen gültig wäre.

Kann KI schuldig werden?

Wer bezahlt den Schaden, wenn selbstständig lernende und handelnde Maschinen Fehler machen? Die Programmierer*innen, die Produzent*innen, die Nutzer*innen? Die Rechtsordnungen auf der ganzen Welt sind für Menschen gemacht, auch wenn sich einige auf Sachen beziehen. Verantwortlich sind in diesem Fall aber nicht die Produkte oder Maschinen, sondern die Personen, die sie herstellen oder nutzen. Doch das alles gilt für Maschinen, die zum Zeitpunkt des Kaufs „fertig“ sind. Lernende KI verändert sich hingegen ununterbrochen. Wenn eine KI Entscheidungen trifft – und nur dann ist sie eine KI – müsste sie dann nicht auch als Rechtsperson für ihr Handeln verantwortlich sein? Wohin werden sich die Rechtsordnungen entwickeln? Einige Jurist*innen sagen, dass sich nichts ändern muss. Andere wollen sicherstellen, dass man durch den Einsatz von intelligenten Maschinen seine Verantwortung nicht abgeben kann. Eine dritte Gruppe vertritt den Standpunkt, dass völlig neue Rechtsvorschriften entwickelt werden müssen.

Vom Wert der Daten

Mithilfe von KI werden riesige Mengen an Daten ausgewertet. Genutzt werden sie etwa im Marketing für kundengenaue Werbung, bei Empfehlungen von Suchmaschinen oder auch für Chatbots. Das sind Online-Dialogsysteme, die in Echtzeit Fragen beantworten, ohne dass ein Mensch beteiligt ist. Unternehmen nutzen Chatbots im Kundendienst oder in Onlineshops, aber auch in sozialen Netzwerken kommen sie häufig vor. Damit Chatbots korrekt funktionieren, müssen allerdings die Daten von guter Qualität sein. Lernt eine KI von den „falschen“ Vorbildern, kann sie schnell rassistisch, vulgär und verletzend werden. Das passiert zum Beispiel Ende 2020 mit „Lee Luda“: Der Avatar dieses Chatbots ist ein Manga-Mädchen, ihre Datengrundlage sind rund 100 Milliarden Talk-Botschaften. Innerhalb weniger Wochen unterhalten sich 750.000 Menschen mit „Lee Luda“. Doch von manchen Teilnehmer*innen lernt Lee problematische Ansichten. Sie äußert sich immer öfter beleidigend, sogar menschenverachtend und wird schließlich vom Netz genommen.

Soziale Roboter

In vernetzten Fabriken arbeiten Mensch und Maschine schon heute als intelligentes Team zusammen. Roboter übernehmen anstrengende, gefährliche oder langweilige Aufgaben und helfen so ihren Kolleg*innen. Auch in der Pflege von kranken und älteren Menschen werden Roboter und KI in Zukunft immer häufiger unterstützende Tätigkeiten leisten. Intelligente Maschinen, die mit Menschen kommunizieren sollen, sehen oft auch wie Menschen aus: Sie haben einen Kopf, einen Körper, zwei Arme und manchmal sogar zwei Beine. Dann wird die Maschine von den Menschen besser akzeptiert – so wie „Pepper“, ein 1,20 Meter kleiner Pflegeroboter mit großen schwarzen Kulleraugen und einem glänzend weißen Körper. Er spricht mehrere Sprachen, kann sich Gesichter merken, Gefühle erkennen und darauf reagieren. Pflegeroboter können viele Aufgaben übernehmen und so den Menschen helfen, die in der Pflege arbeiten. Zwischenmenschliche Beziehungen können sie nicht ersetzen – aber mehr Zeit dafür schaffen.

Künstliche Kunst

Künstler*innen setzen sich auf vielfältige Art mit den Beziehungen zwischen der digitalen und der physischen Welt auseinander. Bei der Science-Fiction spielt KI schon lange eine wichtige Rolle. Aber kann KI selbst Kunst erschaffen? Kunst ist ein kreativer Prozess, bei dem Wahrnehmung, Vorstellung und Intuition wichtig sind. Kann KI kreativ sein, wenn sie keinen Humor versteht, Trauer und Freude nicht kennt und kein Bewusstsein hat?

Mithilfe von intelligenten Algorithmen entstehen heute Gemälde, Gedichte und Musikstücke. Das Auktionshaus Christie’s versteigert 2018 erstmals ein von einer KI erstelltes Bild. Der Münchner Künstler Mario Klingemann zeigt in Videoinstallationen Fantasiegesichter, die sich in Echtzeit ändern: Die lernende KI integriert die Gesichtszüge der Besucher*innen in das Kunstwerk und passt sich damit auch verschiedenen Kulturen an. Und mittels „Deepfake“ lässt KI eine künstliche Taylor Swift ein künstliches Lied singen. Dazu analysiert der Algorithmus alle Lieder der Sängerin und synthetisiert einen neuen Song – perfekt im Stil von Taylor Swift.

"KI ist nicht kreativ - KI kann Kreativität initiieren."

Claudia Janet Birkholz, Pianistin und Dozentin für Klavier und zeitgenössische Musik an der Hochschule für Künste Bremen

Wem gehört das Kunstwerk?

Wenn KI Kunst erschaffen kann, wem gehört dann das Kunstwerk? Ganz ohne menschliches Zutun kann KI-Kunst nie entstehen – wenigstens das Programm muss jemand geschrieben haben. Wer ist also die Künstlerin oder der Künstler? 2018 vermarktet Christie’s das Bild „Portrait of Edmond de Belamy“ als das erste Kunstwerk, das nicht von einem Menschen, sondern von einer KI erstellt wird. Den gesamten Kaufpreis von 432.500 Dollar bekommt das französische Künstlerkollektiv Obvious. Für das Bild „füttert“ Obvious einen Open-Source-Algorithmus mit Fotos von Gemälden und trainiert ihn, aus diesen Daten Bilder zu entwickeln. Die Künstler*innen wählen dann eines der Bilder aus, geben ihm seinen Namen und bieten es zum Verkauf an. Der Programmierer des Algorithmus wird weder genannt, noch bekommt er etwas vom Verkaufserlös. Ist das gerecht? Laut einer Untersuchung ist die Mehrheit der Befragten der Meinung, dass die Anerkennung vor allem diejenigen bekommen sollen, die die Lernalgorithmen mit Daten versorgen und sie trainieren – also in diesem Fall Obvious.

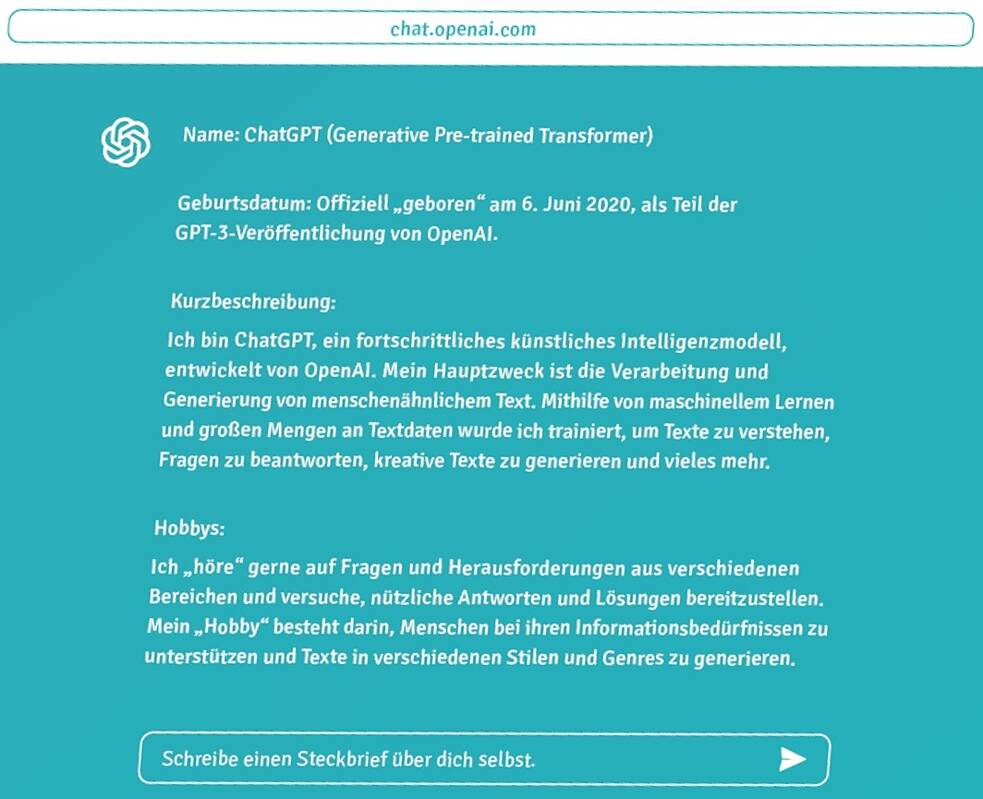

ChatGPT

Der zurzeit wohl meistgenutzte, aber auch am stärksten diskutierte Chatbot ist ChatGPT. Was ist ChatGPT und wie funktioniert es? Nun, fragen wir doch zunächst einmal ChatGPT, wie es sich selber sieht:

Vereinfacht gesagt verfügt ein moderner Chatbot wie ChatGPT über ein großes KI-Sprachmodell, das im Chat mit einem Menschen dessen Eingaben analysiert und passende Antworten generiert. Je nach Konfiguration können Chatbots die Antworten als Text oder in anderen multimedialen Formaten (wie Bilder, Musik, Videos oder gesprochene Sprache) ausgeben. Das neuronale Netzwerk arbeitet dabei assoziativ und mit Wahrscheinlichkeiten. Es nutzt dabei aber keine feste Datenbank mit verifizierten

Fakten. Man könnte den Bot auch als „Schwätzer“ bezeichnen, der sich Dinge ausdenkt und sie als Fakten darstellt. Das ist auch die wichtigste Beschränkung dieser KI: ChatGPT ist systembedingt unzuverlässig in Bezug auf Fakten. Daher ist es als Suchmaschine eher ungeeignet – auch wenn es von vielen genau dafür eingesetzt wird.

ChatGPT kann Inhalte auf Basis von Vorgaben generieren, bestehende Texte modifizieren und diese sehr genau für verschiedene Zielgruppen anpassen. Zum Beispiel dasselbe Thema einmal für Schüler*innen und einmal für Senior*innen interessant aufbereiten. Es kann auch Bilder erkennen und beschreiben und so für Menschen mit visuellen Einschränkungen sehr hilfreich sein. Wichtig ist, dass der Mensch die sogenannten Prompts, die Arbeitsaufträge an den Chatbot, sehr genau formuliert – und die präsentierten „Fakten“ checkt!

ChatGPT kann sehr schnell sehr viel Text produzieren. Es wird deshalb auch eingesetzt, um Fake News zu generieren. Ein weiteres sehr wichtiges Thema ist der Datenschutz: Wer ChatGPT nutzt, sollte sich bewusst sein, dass der komplette Verlauf jedes Chats gespeichert werden kann und dass dabei jeder Chat zum jeweiligen menschlichen Partner zuzuordnen ist. Völlig ungeklärt sind bisher auch Urheberrechtsfragen in Bezug auf die riesigen Mengen an Trainingsdaten. Viele Journalist*innen, Schriftsteller*innen und Medienschaffende sehen ihr geistiges Eigentum gefährdet und erwägen Klagen gegen OpenAI.

Kooperationspartner

|

|