Individus contre robots

« Que nous soyons ou non heureux, l’évolution n’en a que faire »

A-t-on le droit de commettre un acte de violence contre des robots humanoïdes ? Quand l’un d’entre eux réclamera pour la première fois l’application des droits civiques à son encontre, il sera trop tard, nous dit Thomas Metzinger, spécialiste en neuro-éthique. Pourquoi ces robots créent en nous des « hallucinations sociales » et en quoi cela influence notre psyche.

Monsieur Metzinger, dans les hôtels japonais des robots humanoïdes sont déjà utilisés comme portiers et des entreprises américaines ont présenté récemment une nouvelle génération de poupées gonflables qui parlent et réagissent au toucher. Les robots nous ressemblent-ils de plus en plus ?

Dans les domaines où les individus interagissent avec les machines, nous allons voir de plus en plus de telles interfaces aux allures humanoïdes. Même si cela ne représente qu’une petite partie de la robotique, la technique est aujourd’hui très avancée en matière d’interfaces anthropomorphiques. Il est possible d’effectuer quelques mesures sur votre tête en l’espace de 20 minutes au laboratoire et de réaliser à partir des données recueillies un avatar absolument fidèle à votre image, nous pouvons lui conférer une succession de regards différents et faire apparaître des émotions sur l’expression de son visage. Si par ailleurs nous dérobons des données audio sur votre téléphone portable, votre avatar ira jusqu’à adopter votre voix. Dans une conversation en visiophonie, on ne fera pas la différence entre lui et vous.

Vous vous intéressez depuis des années à l’image que les individus ébauchent ou ont d’eux-mêmes. Voyez-vous un problème, en tant que spécialiste en neuro-éthique, à ce que bientôt nos bornes d’achat de billets de transport ressemblent aux employés que nous voyons habituellement au guichet ?

Je crains que ces robots humanoïdes servent dans la plupart des cas à manipuler les consommateurs. Les robots analyseront aussi votre gestuelle et ils commenceront à comprendre quand le client s’ennuie et ce qu’il voudrait entendre.

Si l'ordinateur déraille, nous l'insultons

Et est-ce que la machine peut utiliser cela ?Nous avons dans notre cerveau ce qu’on appelle des neurones miroirs. Quand quelqu’un vous sourit, vous l’imitez de manière subliminale à l’aide des muscles de votre visage. On peut utiliser cette faculté pour influencer les gens. Les robots anthropomorphiques ne montrent pas qu’ils sont surtout tenus par les intérêts de ceux qui les ont programmés, et non par les nôtres. C’est ce qui se passe avec l’algorithme de Google qui optimise les résultats d’une recherche non pas pour les utilisateurs, mais pour les annonceurs. Si spontanément vous trouvez une machine sympathique, vous allez peut-être commander la version suivante de votre produit parce que celle-ci a un sourire communicatif.

Je sais pourtant que je communique avec un robot.

Peut-être pas. Les robots humanoïdes provoquent en nous ce que j’appelle des « hallucinations sociales ». Nous les Hommes, nous avons la faculté d’imaginer que nous communiquons avec quelqu’un qui dispose d’une conscience de soi, même si ce n’est pas le cas. Il existe des étapes préliminaires à ce phénomène : les enfants et les peuples premiers croient souvent à une nature animée. Si l’ordinateur déraille, nous l’insultons. D’autres personnes aiment leurs voitures, certaines ne supportent pas l’absence de leur portable.

Ils sont alors un peu timbrés, non...

Mais sur le plan de l’évolution, ça fait sens. Imaginez que vous vous trouvez la nuit dans une forêt. Vous entendez un bruit dans les buissons. Ceux qui survivent sont bien sûr ceux qui ont eu, en pareil cas, dix fois la vision d’un prédateur et non ceux qui ont manqué celui-ci une seule fois. L’évolution a en quelque sorte récompensé le délire de persécution. C’est précisément pour cela que les hommes ressentent encore aujourd’hui des peurs irrationnelles aussi souvent. Que nous soyons ou non heureux, l’évolution n’en a que faire.

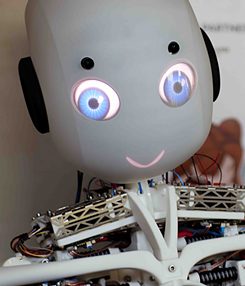

Roboy

| © Roboy 2.0 – roboy.org

Malgré tout, certains fabricants évitent intentionnellement de faire trop ressembler leurs robots à de vrais êtres humains. Le « Roboy » allemand par exemple fait plutôt penser à Caspar, le gentil fantôme avec sa tête de poupon.

Roboy

| © Roboy 2.0 – roboy.org

Malgré tout, certains fabricants évitent intentionnellement de faire trop ressembler leurs robots à de vrais êtres humains. Le « Roboy » allemand par exemple fait plutôt penser à Caspar, le gentil fantôme avec sa tête de poupon.Si le robot paraît trop authentique, beaucoup de gens trouvent effectivement cela effrayant. Les chercheurs nomment cette zone grise la „uncanny valley“, la vallée mystérieuse. C’est comme dans un film d’épouvante. Si nous avons l’impression que nous sommes regardés par quelque chose qui est mort, cela touche à des peurs ancestrales.

Les robots sont un sujet qui intéresse en réalité les Hommes depuis des millénaires. Dans L’Iliade déjà, Héphaistos crée des servantes automates. Comment expliquez-vous cette fascination ?

Leur souhait de jouer un peu le rôle des dieux en est certainement une des raisons. Par ailleurs, la peur de la mort est un élément important. Avec le transhumanisme, c’est aujourd’hui une nouvelle forme de religion qui est née ; elle se passe certes d’église et de dieux, mais elle a pour fonction principale de refuser la mortalité. Les robots et surtout les avatars suggèrent un espoir de pouvoir vaincre la mort en continuant à vivre dans des corps artificiels. Pour certains chercheurs, rien ne saurait être plus grand que d’être le premier à réussir la création d’un robot à intelligence voire à conscience humaine.

Selon une étude, sur 100 experts, 90 pensent que nous verrons cela d’ici 2070.

Je ne mettrais pas trop en avant de telles prévisions. Dans les années 60, on pensait que vingt ans plus tard on aurait des machines aussi rusées que les Hommes. Avec de telles déclarations, on fait rentrer facilement de l’argent dans les caisses de la recherche. Et quand elles se révèlent fausses, l’expert n’est déjà plus en vie.

Les frontières entre l’Homme et la machine deviennent de plus en plus floues.

Qu’est-ce qu’un robot en fait ? Qu’est-ce qui le différencie d’une machine ?Je dirais que c’est une question de degré d’autonomie. Une machine doit être démarrée et stoppée par quelqu’un. Beaucoup de robots peuvent le faire seuls. Et les robots ont en général une plus grande flexibilité qu’une perceuse par exemple, car ils sont programmables.

Si on définit la vie comme de la matière organisée avec une faculté de se reproduire, n’est-il pas possible de dire que les robots, programmés pour construire de nouveaux modèles, sont eux aussi de la vie ?

Non, parce qu’ils n’ont pas de métabolisme. Mais il ne sera peut-être pas aussi facile de différencier à l’avenir les systèmes naturels des systèmes artificiels. Si par exemple nous fabriquons du matériel informatique qui ne se compose plus de métal ou de puces en silicium, mais de cellules génétiquement modifiées. Il serait alors tout à fait possible qu’il existe bientôt des systèmes qui ne soient ni artificiels ni naturels.

Des séries télé comme Westworld prédisent que nous traiterons les robots comme des esclaves. Voyez-vous aussi les choses ainsi ?

C’est possible. Mais on doit bien dissocier deux choses. Il y a une grande différence entre des systèmes qui sont intelligents et des systèmes capables de ressentir de la souffrance. Peut-on être violent avec Dolores, l’androïde de Westworld ? Le véritable problème éthique ici est qu’un tel comportement nuirait au modèle que nous avons construit de nous-mêmes.

De quelle manière ?

C’est la même chose que pour la réalité virtuelle. S’il devient également possible de consommer des actions punissables, il sera facile de se traumatiser soi-même. On se dégrade. Par exemple, cela n’a rien à voir de regarder des films pornos violents en deux dimensions ou d’être « plongé » dans un univers à trois dimensions en ayant la possibilité de faire une expérience tactile. Il est donc probable que côtoyer des robots humanoïdes sans respect particulier mène à la généralisation de comportements asociaux. En outre, les Hommes ont toujours utilisé les systèmes techniques les plus modernes comme des métaphores pour se décrire eux-mêmes. Lorsqu’en 1650 apparurent les premières montres et les premiers personnages mécaniques, Descartes décrivit le corps comme une machine. Le jour où nous rencontrerons partout des robots humanoïdes, nous pourrons nous demander si nous ne nous considérons pas plutôt comme des automates génétiquement déterminés, comme des bio-robots. Les frontières entre l’Homme et la machine deviennent de plus en plus floues.

« Comment ça, une machine ? Ça a toujours été mon ami ! »

Avec quelles conséquences dans la vie quotidienne ?Imaginez que les membres d’une génération grandissent en jouant avec des robots ou des avatars qui vivraient de façon si authentique que la distinction entre ce qui est vivant ou mort, entre le rêve et la réalité ne soit plus aussi clairement établie dans leur cerveau qu’elle l’est encore pour nous aujourd’hui. Cela ne voudra pas nécessairement dire que ces enfants n’auront pas moins de respect pour la vie. Mais je peux déjà imaginer que lors d’une discussion d’ordre moral, quelqu’un tape sur la table en disant : « Et attendez, ce n’est qu’une machine ! » La réponse serait alors : « Comment ça, une machine ? Ça a toujours été mon ami ! »

C’est pourquoi des philosophes comme Julian Nida-Rümelin demandent à ce que de tels robots ne soient pas construits.

Pour faire une réponse plus nuancée, on devrait se demander s’il n’existe pas des possibilités d’utilisation plus judicieuses. Des robots humanoïdes soignants pourraient par exemple donner le sentiment à des malades souffrant de démence de ne pas être seuls. On peut bien sûr ne pas être d’accord et se demander si ce n’est pas préjudiciable ou condescendant envers le patient.

Quelles limites imposeriez-vous ?

Selon moi, le point décisif n’est pas l’apparence des robots, mais il faut dire s’ils ont ou non une conscience, s’ils peuvent ou non ressentir de la souffrance. Et pour cette raison, je suis sur le plan de l’éthique de la recherche absolument contre le fait de pourvoir les machines, ne serait-ce que d’une ébauche de modèle de conscience, d’une conscience de soi. Je sais qu’on en est encore loin. Mais à partir du moment où un premier robot réclamera des droits civiques, il sera trop tard. Je demande un moratoire pour la phénoménologie de synthèse.

Nous aurions donc besoin, à moyen terme, de quelque chose qui ressemblerait à un code éthique global pour la robotique.

Oui, même s’il est clair que les Global Players l’ignoreraient, comme le font les États-Unis aujourd’hui avec le Tribunal pénal international. Je trouve particulièrement surprenant que lors de la plupart des discussions qui sont d’ores et déjà menées aujourd’hui sur ce thème, il ne soit pas du tout question d’éthique, mais seulement de sécurité pénale et de responsabilité.

L’intelligence artificielle nous oblige aussi à nous confronter à nous-mêmes.

Parce qu’en cas de doute, cela peut coûter beaucoup d’argent ?Bien sûr. Il en résulte vraiment de nombreuses interrogations. Imaginez qu’une voiture Google roule autour d’un rond-point, avec trois voitures autonomes et deux voitures normales. Un chien s’aventure alors sur la route. Les voitures reconnaissent qu’il va y avoir un accident et doivent calculer le moindre dommage. Que vaut la vie d’un animal ? Que vaut la vie de quelqu’un qui n’est pas client chez Google ? Que se passe-t-il si l’une des personnes concernées est un enfant ou une femme enceinte ? Est-ce que cela compte double ? Qu’en est-il pour les pays musulmans où les femmes ne possèdent que des droits restreints ? Est-ce que le nombre de survivants masculins est important là-bas ? Que se passe-t-il si des chrétiens se trouvent dans l’autre voiture ? L’avantage dans la robotique, c’est qu’on doit enfin se prononcer clairement sur toutes ces questions. L’intelligence artificielle nous oblige aussi à nous confronter à nous-mêmes.

Le philosophe Éric Sadin a écrit dans « Die Zeit » que céder notre pouvoir de décision à des algorithmes serait une attaque à la condition humaine.

Il s’agit en effet d’un mécanisme unique dans l’Histoire que d’abandonner notre autonomie à des machines. Le problème fondamental est que chaque étape individuelle devrait être assurée de façon rationnelle, voire éthique. Mais bien sûr le risque que cette évolution nous échappe existe.

Avec quelles conséquences ?

La robotique militaire représente un problème particulier. Les drones vont être bientôt si rapides et si intelligents qu’il ne sera plus utile de consulter un officier dans une situation de combat. C’est une course aux armements qui commence et, à un moment donné, il faudra bien que les systèmes réagissent les uns aux autres de manière indépendante. C’est ce que nous avons déjà connu en 2010 avec les systèmes de trading à la bourse, notamment avec le Flash Crash lors duquel il y eut des milliards de pertes en l’espace de quelques secondes. Qui sait quelles pertes pourraient produire un Flash Crash d’ordre militaire.

La vision d’horreur montrant des machines qui peuvent un jour devenir dangereuses pour nous est l’un des sujets favoris de la science-fiction. Aujourd’hui, des chercheurs reconnus comme Nick Brostrom de l’université d’Oxford, préviennent effectivement du danger que pourrait représenter une super-intelligence non maîtrisée.

On peut bien sûr spéculer en nous demandant si nous ne sommes que les horribles précurseurs biologiques d’une nouvelle étape de l’évolution. Mais selon moi, il est complètement absurde de dire que les robots sont en train de construire des usines en toute autonomie et de nous enfermer dans des réserves. Par ailleurs, de nouveaux types de problèmes pourraient survenir si une super-intelligence morale, qui ne nous voudrait que du bien, en venait à dire qu’il serait mieux pour nous de ne plus exister pour le motif que notre propre vie est principalement faite de souffrance. Mais le plus gros problème en ce moment n’est sûrement pas que de méchantes machines nous piétinent, mais plutôt que la technologie ouvre de nouvelles voies pour nous contrôler à distance. Quand les algorithmes commencent à optimiser de façon autonome des activités ou de nouveaux chemins pour les flux d’information sur des réseaux sociaux, alors des processus politiques pourraient être manipulés sans que nous le remarquions.

Martin Ford, un des pionniers de la Silicon Valley craint avant tout dans son livre Rise of the Robots (L’avènement des machines) des conséquences économiques.

Oui, il y a des études qui annoncent que d’ici 2030 le nombre d’emplois va chuter de 47 %. Les super-riches et leurs analystes prennent cela tout à fait au sérieux parce qu’ils voient que l’arrivée des robots les rendra encore plus riches et les pauvres encore plus pauvres. Et ils voient aussi que les pays qui réussissent aujourd’hui la transition vers l’intelligence artificielle sèmeront définitivement ceux qui échouent. Dans le passé, on avait coutume de dire très naïvement : « À chaque fois qu’apparurent de nouvelles technologies dans l’histoire de l’humanité, de nouveaux métiers ont émergé simultanément. » Cette fois, cela pourrait s’avérer un vœu pieux.

Thomas Metzinger

| © IGU Pressestelle

Thomas Metzinger

Thomas Metzinger

| © IGU Pressestelle

Thomas Metzinger

Thomas Metzinger, 59 ans, nous reçoit à l’université de Mayence. Il dirige le département de Philosophie théorique, est directeur du groupe MIND et du centre de recherches en neuro-éthique. De 2005 à 2007, il a été président de la Gesellschaft für Kognitionswissenschaft (Société des sciences cognitives). Il s’intéresse plus particulièrement à la recherche sur la conscience humaine. Thomas Metzinger affirme que nous ne disposons ni de quelque chose comme un Soi ni d’une âme mais que nous avons dans notre cerveau un « self model » que nous ne percevons pas comme un modèle. Il développe cette théorie dans son livre Der Ego-Tunnel (Le tunnel du Moi ; éd. Piper) d’une manière accessible aux amateurs. Metzinger soutient les relations entre la philosophie de l’esprit et la recherche sur le cerveau et s’intéresse ainsi depuis plus d’un quart de siècle à l’intelligence artificielle. Il possède lui-même un aspirateur robot qui le ravit absolument. Il ne lui a toutefois pas encore donné de nom.