Menschen gegen Roboter

„Der Evolution ist ja egal, ob wir glücklich sind"

Darf man humanoiden Robotern Gewalt antun? Wenn der erste von ihnen Bürgerrechte fordert, ist es zu spät, sagt der Neuroethiker Thomas Metzinger. Warum humanoide Roboter bei uns "soziale Halluzinationen" erzeugen und was das mit unserer Psyche macht.

Von Moritz Honert

Herr Metzinger, in japanischen Hotels werden bereits humanoide Roboter als Concierges eingesetzt, US-Firmen haben kürzlich eine neue Generation von Sexpuppen vorgestellt, die sprechen und auf Berührung reagieren können. Werden Roboter uns immer ähnlicher?

In Bereichen, in denen Menschen mit Maschinen interagieren, werden wir solche humanoid aussehenden Schnittstellen zunehmend erleben. Das ist zwar nur ein kleiner Teil der Robotik, aber was diese anthropomorphen Interfaces angeht, ist die Technik inzwischen sehr weit. Im Labor können wir in 20 Minuten Ihren Kopf vermessen und aus den Daten einen fotorealistischen Avatar erstellen, wir können ihm Blickfolgebewegungen und emotionale Gesichtsausdrücke geben. Wenn wir dazu von Ihrem Handy Audiodaten klauen, kann der sogar sprechen wie Sie. Bei der Videotelefonie wäre Ihr Avatar von Ihnen nicht mehr zu unterscheiden.

Sie beschäftigen sich seit Jahren mit dem Bild, das der Mensch von sich hat und entwirft. Sehen Sie als Neuroethiker Probleme, wenn unsere Fahrkartenautomaten bald aussehen wie Schalterbeamte?

Ich fürchte, dass diese humanoiden Roboter in den allermeisten Fällen der Konsumentenmanipulation dienen werden. Schließlich wird der Roboter ja auch Ihre Mimik analysieren und anfangen zu verstehen: Langweilt sich der Kunde? Was will er eigentlich hören?

Wenn der Computer spinnt, brüllen wir ihn an.

Und das kann die Maschine nutzen?Wir besitzen im Gehirn sogenannte Spiegelneuronen. Wenn ein Mensch Sie anlächelt, dann ahmen Sie das mit ihrer Gesichtsmuskulatur unterschwellig nach. Das kann man zur Beeinflussung nutzen. Menschenähnliche Roboter verschleiern, dass sie in erster Linie nicht unseren, sondern den Interessen ihrer Programmierer verpflichtet sind. So wie Googles Algorithmus seine Treffer auch nicht für die Nutzer, sondern für seine Werbetreibenden optimiert. Wenn Sie eine Maschine aber unwillkürlich nett finden, dann buchen Sie vielleicht noch ein Upgrade, weil sie so ansteckend lächelt.

Aber ich weiß doch, dass ich es mit einem Roboter zu tun habe.

Vielleicht auch nicht. Humanoide Roboter lösen etwas in uns aus, was ich „soziale Halluzinationen“ nenne. Wir Menschen haben die Fähigkeit, uns einzubilden, es mit einem selbstbewussten Gegenüber zu tun zu haben, auch wenn das nicht der Fall ist. Davon gibt es Vorstufen: Kinder und Naturvölker glauben oft an eine beseelte Natur. Wenn der Computer spinnt, brüllen wir ihn an. Andere Menschen lieben ihr Auto oder vermissen ihr Handy.

Klingt plemplem.

Ist aber evolutionär sinnvoll. Stellen Sie sich vor, Sie sind nachts in einem dunklen Wald. Im Gebüsch raschelt es. Überlebt haben natürlich die, die da zehnmal eher ein Raubtier halluziniert haben, als die, die das einmal verpasst haben. Die Evolution belohnte hier in gewissem Sinn Verfolgungswahn. Und deshalb haben wir Menschen auch heutzutage noch so oft irrationale Ängste. Der Evolution ist es ja egal, ob wir glücklich sind.

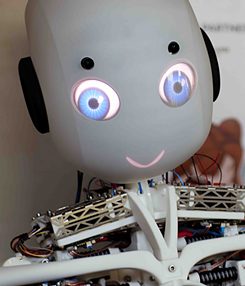

Roboy

| © Roboy 2.0 – roboy.org

Trotzdem vermeiden einige Hersteller bewusst, ihre Roboter zu sehr wie wirkliche Menschen aussehen zu lassen. Der deutsche „Roboy“ zum Beispiel sieht mit seinem Kindchenschemakopf eher aus wie Caspar, das freundliche Gespenst. Wirkt der Roboter zu echt, finden das viele Menschen tatsächlich gruselig. Forscher nennen diese Grauzone „uncanny valley“, das unheimliche Tal. Das ist wie in einem Horrorfilm. Wenn wir merken, da schaut uns etwas an, das eigentlich tot ist, rührt das an Urängste.

Roboy

| © Roboy 2.0 – roboy.org

Trotzdem vermeiden einige Hersteller bewusst, ihre Roboter zu sehr wie wirkliche Menschen aussehen zu lassen. Der deutsche „Roboy“ zum Beispiel sieht mit seinem Kindchenschemakopf eher aus wie Caspar, das freundliche Gespenst. Wirkt der Roboter zu echt, finden das viele Menschen tatsächlich gruselig. Forscher nennen diese Grauzone „uncanny valley“, das unheimliche Tal. Das ist wie in einem Horrorfilm. Wenn wir merken, da schaut uns etwas an, das eigentlich tot ist, rührt das an Urängste.Tatsächlich beschäftigt das Thema Roboter den Menschen seit Jahrtausenden. Bereits in der Ilias erschafft Hephaistos automatische Dienerinnen. Wie erklären Sie diese Faszination?

Ein Motiv ist sicher der Wunsch, selbst ein wenig Gott zu spielen. Außerdem dürfte die Angst vor dem Tod ein wichtiger Punkt sein. Mit dem Transhumanismus ist ja jetzt auch eine neue Form der Religion entstanden, die ohne Kirche und Gott auskommt, aber trotzdem als Kernfunktion die Sterblichkeitsverleugnung anbietet. Roboter und vor allem Avatare suggerieren die Hoffnung, wir könnten den Tod besiegen, indem wir einst in künstlichen Körpern weiterleben. Für manchen Forscher wäre es aber auch das Allergrößte, wenn es ihm als Erstem gelänge, einen Roboter mit menschlicher Intelligenz oder gar Bewusstsein zu entwickeln.

Einer Studie zufolge gehen 90 von 100 Experten davon aus, dass wir das bis 2070 erleben werden.

Solche Prognosen würde ich nicht zu hoch hängen. In den 1960ern dachte man auch schon, es dauert höchstens noch 20 Jahre, bis wir Maschinen haben, die so schlau sind wie Menschen. Mit solchen Aussagen lassen sich gut Gelder für die Forschung eintreiben, und wenn sie sich als falsch erweisen, lebt der Experte nicht mehr.

Die Grenzen zwischen Mensch und Maschine werden fließender.

Was ist ein Roboter überhaupt, was unterscheidet ihn von einer Maschine?Ich würde das über den Grad der Autonomie definieren. Eine Maschine muss von uns gestartet und gestoppt werden. Viele Roboter können das selbstständig. Und Roboter haben allgemein eine größere Flexibilität als zum Beispiel eine Bohrmaschine, sie sind programmierbar.

Wenn man Leben definiert als organisierte Materie mit der Fähigkeit zur Fortpflanzung: Wären Roboter, die man programmiert, neue Modelle zu bauen, nicht auch Leben?

Nein, weil sie keinen Stoffwechsel haben. Aber die Unterscheidung zwischen natürlichen und künstlichen Systemen wird in Zukunft vielleicht auch nicht mehr so einfach zu treffen sein. Wenn wir zum Beispiel Hardware herstellen, die nicht mehr aus Metall oder Siliziumchips besteht, sondern aus gentechnisch gezüchteten Zellen. Gut möglich, dass es bald Systeme gibt, die weder künstlich noch natürlich sind.

TV-Serien wie „Westworld“ prophezeien, dass wir die Roboter wie Sklaven behandeln werden. Sehen Sie das auch so?

Möglich. Aber man muss ganz klar zwei Sachen auseinanderhalten. Es ist ein großer Unterschied, ob diese Systeme intelligent oder ob sie tatsächlich leidensfähig sind. Darf man Dolores, der Androidin aus „Westworld“, Gewalt antun? Das eigentliche ethische Problem ist, dass ein solches Verhalten unser Selbstmodell beschädigen würde.

Wie das?

Das ist ähnlich wie bei virtuellen Realitäten. Wenn auf diesem Wege auch strafbare Handlungen konsumierbar werden, passiert es leicht, dass die Schwelle zur Selbsttraumatisierung überschritten wird. Man verroht. Es ist etwas ganz anderes, ob beispielsweise Gewaltpornos zweidimensional betrachtet werden oder „eingetaucht“ dreidimensional und haptisch erlebbar sind. Durchaus möglich also, dass ein respektloser Umgang mit humanoiden Robotern zu generell asozialem Verhalten führt. Darüber hinaus hat der Mensch die neuesten technischen Systeme stets als Metaphern benutzt, um sich selbst zu beschreiben. Als 1650 die ersten Uhren und mechanischen Figuren auftauchten, beschrieb Descartes den Körper als Maschine. Wenn uns jetzt überall humanoide Roboter begegnen, dann stellt sich die Frage, ob wir uns nicht auch stärker als genetisch determinierte Automaten, als Bioroboter, begreifen. Die Grenzen zwischen Mensch und Maschine werden fließender.

„Wie? Maschine? Das ist mein Freund!"

Mit welchen Folgen für den Alltag?Stellen Sie sich vor, es wächst eine Generation heran, die mit Robotern oder Avataren spielt, die so lebensecht sind, dass die Unterscheidung zwischen lebendig und tot, Wirklichkeit und Traum im Gehirn nicht mehr in dem Maße ausgebildet wird wie noch bei uns. Das muss nicht dazu führen, dass diese Kinder automatisch weniger Achtung vor dem Leben haben. Ich kann mir aber schon vorstellen, dass in 20 Jahren in einem ethischen Streitgespräch mal jemand auf den Tisch haut und sagt: „Jetzt mal langsam, das ist bloß eine Maschine!“ Und die Antwort dann lautet: „Wie? Maschine? Das ist mein Freund! Immer gewesen.“

Philosophen wie Julian Nida-Rümelin fordern deshalb, wir sollten humanoide Roboter gar nicht bauen.

Für eine differenziertere Lösung sollte man sich fragen, ob es nicht tatsächlich auch sinnvolle Einsatzmöglichkeiten gibt. Humanoide Pflegeroboter könnten beispielsweise demenzkranken Menschen das Gefühl geben, nicht allein zu sein. Natürlich könnte man diskutieren, ob das nicht wiederum entwürdigend oder bevormundend gegenüber den Patienten ist.

Welche Grenzen würden Sie ziehen?

Der entscheidende Punkt ist für mich nicht, wie die Roboter aussehen, sondern ob sie ein Bewusstsein haben, ob sie leidensfähig sind. Deshalb bin ich forschungsethisch entschieden dagegen, Maschinen auch nur ansatzweise mit einem bewussten Selbstmodell, einem Ich-Gefühl, auszustatten. Ich weiß, das ist noch weit in der Zukunft. Aber wenn der erste Roboter Bürgerrechte fordert, ist es zu spät. Wenn man dann den Stecker zieht, könnte das Mord sein. Ich fordere ein Moratorium für synthetische Phänomenologie.

Also bräuchten wir mittelfristig so etwas wie einen globalen Ethikkodex für die Robotik.

Ja. Wobei völlig klar ist, dass die großen Player den ignorieren würden, so wie die USA heute den Internationalen Strafgerichtshof ignorieren. Besonders bemerkenswert finde ich, dass es bei den meisten Diskussionen, die heute schon zu dem Thema geführt werden, gar nicht um Ethik geht, sondern nur um Rechtssicherheit und Haftung.

Künstliche Intelligenz konfrontiert uns auch mit uns selbst.

Weil es sonst im Zweifelsfall teuer werden kann?Richtig. Es ergeben sich ja wirklich eine Menge Fragen. Stellen Sie sich vor, ein Google-Auto fährt in einen Kreisel, dazu drei weitere selbstfahrende Autos und zwei normale. Dann läuft ein Hund auf die Straße. Die Autos erkennen, es wird einen Unfall geben, und müssen jetzt den geringsten Schaden ausrechnen. Was ist das Leben eines Tieres wert? Was ist das Leben eines Nicht-Google-Kunden wert? Was, wenn einer der Beteiligten ein Kind ist, oder schwanger? Zählt das doppelt? Und wie sieht das in muslimischen Ländern aus, in denen Frauen nur eingeschränkte Rechte besitzen? Ist dort die Zahl der überlebenden Männer wichtig? Was, wenn in dem anderen Auto Christen sitzen? Das ist ja das Schöne an der Robotik, dass wir bei all diesen Fragen nun endlich Farbe bekennen müssen. Die Künstliche Intelligenz konfrontiert uns auch mit uns selbst.

Der Philosoph Éric Sadin schrieb in der „Zeit“, Entscheidungsgewalt an Algorithmen abzutreten sei ein Angriff auf die Conditio humana.

Es ist tatsächlich ein historisch einmaliger Vorgang, dass wir Autonomie an Maschinen abtreten. Das tiefere Problem ist, dass jeder einzelne Schritt rational, sogar ethisch geboten sein könnte. Aber natürlich besteht die Gefahr, dass uns die Entwicklung entgleitet.

Mit welchen Folgen?

Ein besonderes Problem ist die militärische Robotik. Drohnen werden bald so schnell und intelligent sein, dass es nicht mehr sinnvoll ist, in einer Gefechtssituation noch einen Offizier zu fragen. Es beginnt ein Wettrüsten und irgendwann müssen die Systeme unabhängig aufeinander reagieren. Das haben wir ja jetzt schon bei Tradingsystemen an der Börse: 2010 gab es den Flash Crash, bei dem binnen Sekunden Milliardenverluste entstanden. Wer weiß, welche Verluste ein militärischer Flash Crash produzieren würde.

Die Horrorvision, Maschinen könnten uns eines Tages gefährlich werden, ist ein beliebtes Thema der Science-Fiction. Tatsächlich warnen inzwischen auch anerkannte Forscher wie Nick Bostrom von der Oxford-Universität vor einer nicht zu kontrollierenden Superintelligenz.

Natürlich kann man darüber spekulieren, ob wir nur die hässlichen biologischen Steigbügelhalter für eine neue Ebene der Evolution sind. Aber dass Roboter jetzt anfangen, selbstständig Fabriken zu bauen, und uns in Reservaten einsperren, halte ich für völlig absurd. Andererseits könnten tatsächlich neuartige Probleme auftauchen, wenn eine ethische Superintelligenz, die nur das Beste für uns will, zu dem Ergebnis kommt, es wäre für uns besser, nicht zu existieren, weil unser eigenes Leben überwiegend leidvoll ist. Das größere Problem derzeit ist aber sicher nicht, dass die bösen Maschinen uns überrennen, sondern dass diese Technologie neue Tore öffnet, uns fernzusteuern. Wenn Algorithmen anfangen, selbstständig Aktivitäten in sozialen Netzwerken oder Wege von Nachrichtenflüssen zu optimieren, dann könnten politische Prozesse manipuliert werden, ohne dass wir das merken.

Der Silicon-Valley-Entwickler Martin Ford befürchtet in „Der Aufstieg der Roboter“ vor allem wirtschaftliche Folgen.

Ja, es gibt Studien, die legen bis 2030 einen Wegfall von 47 Prozent der Jobs nahe. Die Superreichen und ihre Analysten nehmen dies durchaus ernst, weil sie sehen, dass die Einführung von Robotern sie noch reicher und die Armen noch ärmer machen wird. Und sie sehen auch, dass die Länder, die jetzt den Übergang in die Künstliche Intelligenz schaffen, diejenigen, denen das nicht gelingt, historisch endgültig abhängen werden. In der Vergangenheit hieß es stets ganz naiv: „Immer, wenn in der Geschichte der Menschheit neue Technologien entstanden, sind gleichzeitig auch neue Arbeitsplätze entstanden.“ Das könnte sich diesmal als frommer Wunsch entpuppen.

Thomas Metzinger

| © IGU Pressestelle

Thomas Metzinger

Thomas Metzinger

| © IGU Pressestelle

Thomas Metzinger

Thomas Metzinger, 59, empfängt in einem Büro an der Uni Mainz. Metzinger leitet den Arbeitsbereich Theoretische Philosophie, ist Direktor der MIND Group und der Forschungsstelle Neuroethik. Von 2005 bis 2007 war er Präsident der Gesellschaft für Kognitionswissenschaft. Sein Schwerpunkt ist die Erforschung des menschlichen Bewusstseins. Metzinger sagt, dass wir weder so etwas wie ein Selbst noch eine Seele besitzen, sondern nur ein „Selbstmodell“ im Kopf, das wir nicht als Modell erleben. Eine Theorie, die er in dem Buch „Der Ego-Tunnel“ (Piper) auch für Laien verständlich ausführt. Metzinger tritt für eine Verknüpfung der Philosophie des Geistes mit der Hirnforschung ein und beschäftigt sich dabei seit mehr als einem Vierteljahrhundert auch mit Künstlicher Intelligenz. Er selbst besitzt einen Staubsauger-Roboter, von dem er hellauf begeistert ist. Einen Namen hat er ihm aber noch nicht gegeben.

Kommentare

Kommentieren